Hast du dich schon einmal gefragt, warum und auf welche Weise künstliche Intelligenz in den smarten Plug-ins von sonible arbeitet? sonible’s Mitbegründer Alexander Wankhammer gibt dir Antworten auf diese Frage, macht einen kleinen Exkurs in die Geschichte sonible’s und erzählt von unseren Zielsetzungen bei der Entwicklung von Audiobearbeitungstool mit intelligenter Verarbeitung.

Hinweis: Wir haben smart:EQ 2 durch smart:EQ 3 ersetzt! Der intelligente Equalizer verfügt jetzt über eine zweite KI-gestützte Funktion und wurde umfassend überarbeitet. Die Verarbeitung von smart:EQ 3 ist aber in den grundlegenden Funktionsweisen, wie im Folgenden beschrieben, dieselbe wie in smart:EQ 2.

Alex: Als Peter, Ralf und ich sonible gründeten, haben wir schon von Anfang an mit dem Gedanken gespielt KI einzusetzen. Die Idee Machine Learning (ML) zu nutzen um die Leistung von bereits existierenden Algorithmen zu verbessern hat uns nicht in Ruhe gelassen. Wir haben gesehen, welche Möglichkeiten der Einsatz von ML in anderen Bereichen geschaffen hat und wir wollten an der Situation etwas ändern, dass Musikproduzenten bis dahin kaum von dieser neuen Technologie profitieren konnten.

Mit der Entwicklung von frei:raum, der im Jänner 2015 auf den Markt kam, haben wir begonnen in KI-Technologien einzutauchen. Die smart:EQ-Ebene haben wir mit „klassischen“ Statistik-basierten ML-Algorithmen ausgestattet, um automatisch spektrale Mängel zu beheben. Von ML sind wir dann einen Schritt weitergegangen und haben schließlich begonnen Deep Learning (DL) in unsere Plug-ins zu integrieren.

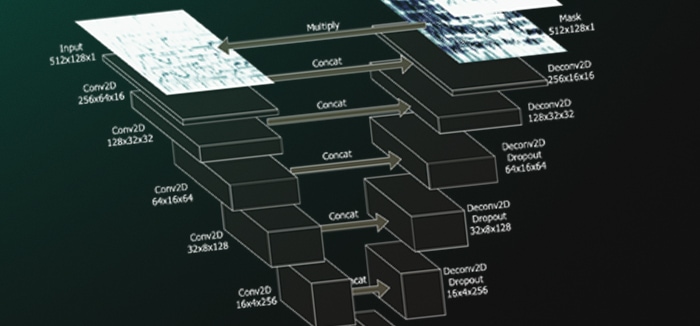

Alex: Wie DL in einem Audio-Plug-in arbeitet, zeigt sich am besten anhand eines Beispiels. Nehmen wir smart:EQ 3 dafür: Sein Kern ist ein System, das hauptsächlich mit der Hilfe von einer riesigen Datenmenge trainiert wird. Das System lernt „schlechte Daten“, die durch spektrale Mängel charakterisiert sind, in „gute Daten“, mit spektraler Balance, zu transformieren. Die Entwicklung von smart:EQ 3 war verbunden mit dem Design einer speziellen Architektur für ein Convolutional Neural Network. Indem wir dem Netzwerk eine Zeit-Frequenz-Repräsentation der „schlechten Daten“ und „gute Daten“ als Ziel für den Output geben – und das tausende Male machen – lernt das Netzwerk wie die Probleme zu beheben sind. Von hier an arbeitet das trainierte Netzwerk dann selbstständig.

Da dieser Prozess rein Daten-getrieben ist, haben Dinge wie Auswahl hoch-qualitativer Daten, Datenaufbereitung und Qualitätskontrolle einen immensen Einfluss auf die Leistung des Gesamtsystems. Aus diesem Grund ist die Generierung von Profilen für die smarten Profile so zeitaufwendig. Die beste Kombination aus Parametern, der richtige Weg, um die Leistung akustisch zu bewerten, Justierungen etc. – das herauszufinden hat Jahre gebraucht und auch heute arbeiten wir daran diesen Prozess ständig zu verbessern.

Um die automatisch generierten Resultate noch weiter zu optimieren, kombinieren wir das Netzwerk mit Model-basierten Methoden.

Alex: Die Daten-getriebene Methode ist eine Art Blackbox. Obwohl die Resultate perfekt für technische Aspekte des Mixens sind, die auf „richtig-falsch“ oder „gut-schlecht“ basieren, wie bspw. Quellen-Separierung oder Instrumentenerkennung, müssen in vielen Fällen kritische Entscheidungen getroffen werden, die ein Verständnis für das Audiomixen voraussetzen. Hier kommen Model-getriebene Methoden ins Spiel. Sie sind zwar bis zu einem gewissen Ausmaß auch Daten-basiert, aber die Algorithmen sind nachvollziehbar und vor allem können sie manuell optimiert werden. Wir haben herausgefunden, dass eine Kombination beider Ansätze für uns aktuell der richtige Weg ist.

Heutzutage gibt es generell drei Richtungen bei denen KI in Tools für die Musikproduktion eingesetzt werden: assistierendes Mixing, das sich hauptsächlich auf das Erkennen und Ausbessern technischer Probleme fokussiert, während der kreative Prozess zur Gänze in den Händen des Produzenten liegt. Dann ist da noch generative KI, die etwa automatisch Melodien oder Akkordfolgen vorschlägt und KI-Effekte, die völlig neuartige Möglichkeiten bieten, um neue Klänge entstehen zu lassen. Und natürlich können alle drei Optionen kombiniert werden.

Wir haben uns für den Zugang des assistierenden Mixens entschieden, das Profis dabei hilft, Zeit bei sich wiederholenden Schritten zu sparen und ambitionierte Anfänger dabei unterstützt, schneller loslegen zu können. Im Grunde ist es unser Ziel, Menschen bei den Basics und der iterativen Grundarbeit zu helfen und schneller in den „kreativen Fluss“ zu finden. Ich finde das Bild schön, unsere Plug-in mit einem persönlichen Mixing-Assistenten zu vergleichen – also einem recht erfahrenen zweiten Tontechniker, der dich bei deiner Arbeit unterstützt.